网卡绑定CPU

- 本节内容在每次服务器重启后,都需要重新执行。

- 服务器上使用多张网卡时,每张网卡均需要进行如下步骤确认。

网络服务占用的CPU与容器绑定的CPU重叠时,会造成容器内CPU资源异常。为了避免这种情况出现,请将流量较大、负载较重的网卡绑定至空闲CPU。

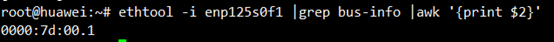

- 执行命令,查看网卡pci设备号。本文以网卡enp125s0f1为例进行说明。

1# ethtool -i enp125s0f1 | grep bus-info | awk '{print $2}'如图中示例所示,网卡enp125s0f1的pci设备号为0000:7d:00.1。

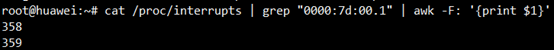

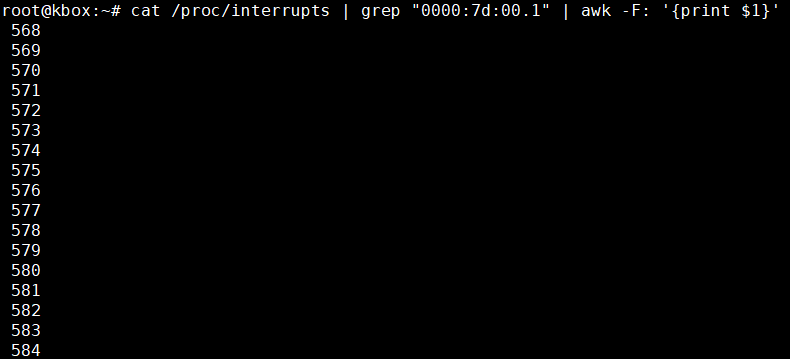

- 执行命令,查询网卡涉及的中断。命令中的${id_pci}为1中查到的网卡设备号。

1# cat /proc/interrupts | grep "${id_pci}" | awk -F: '{print $1}'如图中示例所示,网卡enp125s0f1的pci设备号为0000:7d:00.1,其对应的中断为358、359。

若查询到网卡涉及的中断比较多,如下图示例所示,有17个中断,则需要判断中断是否分散地绑在不同CPU上,根据判断结果来确定是否修改中断绑定的CPU。

- 查询中断绑定在哪个CPU上,命令中的${break_value}为查询到的网卡中断号。

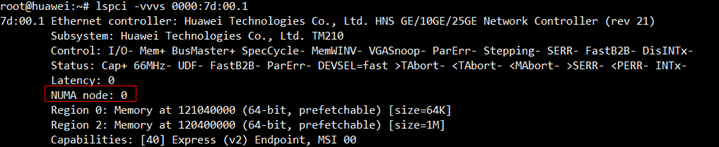

- 根据网卡的pci设备号,查看网卡所属的NUMA node。命令中的${id_pci}为网卡设备号,可通过本节内容的1进行查看。执行命令,回显中的NUMA node参数对应的值即为网卡所属的NUMA node。

1# lspci -vvvs ${id_pci}如图中示例所示,根据pci设备号查询得到的网卡enp125s0f1所属的NUMA node为0。

- 网卡中断绑定至预留CPU(优先网卡所属的NUMA node CPU)上。

命令中的${break_1}、${break_2}依次为两个网卡中断的值。

- 将中断${break_1}绑定至1 CPU。

1# sudo echo 1 > /proc/irq/${break_1}/smp_affinity_list - 将中断${break_2}绑定至2 CPU。

1# sudo echo 2 > /proc/irq/${break_2}/smp_affinity_list

以网卡enp125s0f1为例,它对应的中断为358、359,绑定命令依次为:

1 2

# sudo echo 1 > /proc/irq/358/smp_affinity_list # sudo echo 2 > /proc/irq/359/smp_affinity_list

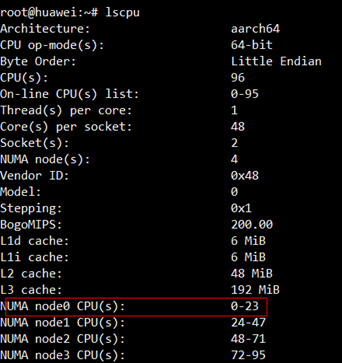

查询得到网卡所属的NUMA node后,NUMA node对应的core区间可通过执行命令查看,参考命令如下:

1# lscpu

如图中示例所示,网卡enp125s0f1所属的NUMA node为0,其对应的core区间为0~23。

- 将中断${break_1}绑定至1 CPU。

父主题: 部署Kbox