添加OSD

OSD是Ceph集群数据管理服务。添加OSD需满足以下所有条件。

- 设备必须没有分区。

- 设备不得具有任何LVM状态。

- 不得安装设备。

- 该设备不得包含文件系统。

- 该设备不得包含Ceph BlueStore OSD。

- 设备必须大于5GB。

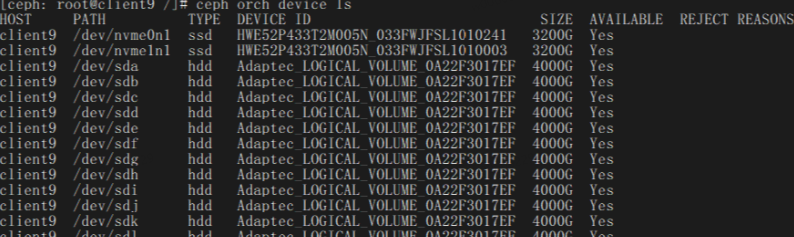

- 查看系统可用盘。

1ceph orch device ls --wide --refresh

- 添加OSD。方式1. 自动添加所有满足条件的OSD。

ceph orch apply osd --all-available-devices

方式2. 手动方式添加OSD(此处以ceph1节点和NVMe SSD盘为例说明)。ceph orch daemon add osd ceph1:/dev/nvme0n1 for node in {1..3};do for i in {0..7};do ceph orch daemon add osd ceph${node}:/dev/nvme${i}n1;done;done方式3. 高级服务规格部署OSD。

通过.yaml配置文件,启动一个部署OSD的服务,通过此方式部署OSD服务有以下优势。

- 可以指定设备。

- 一个盘起多个OSD。

- 可以通过控制服务来重启等。

- 编写osd_spec.yaml文件,在文件中添加如下内容(下面编写两种常用文件),指定可用ssd的方式。

vi osd_spec.yaml 添加如下内容(下面编写两种常用文件): 指定可用ssd的方式 service_type: osd service_id: x18_bluestore placement: hosts: #根据实际各节点名编写 - node1 - node2 - node3 osds_per_device: 1 #一个ssd启osd的数量 #unmanaged: True spec: data_devices: paths: #按ceph orch device ls 得到的可用盘写 - /dev/nvme0n3 - /dev/nvme0n3 - /dev/nvme0n3 - /dev/nvme0n3通过ssd的model的方式自动筛选可用硬盘,并限定该硬盘启动几个osd。 service_type: osd service_id: osd_nvme_1.5T placement: # host_pattern: '*' hosts: #根据实际各节点名编写 - node1 - node2 - node3 osds_per_device: 1 #一个ssd启osd的数量 #unmanaged: True spec: data_devices: model: HWE56P431T6M002N #通过ceph-volume inventory 命令获取ssd的Model limit: 1 #限定该model的盘只能用一块 - 启动OSD服务。

ceph orch apply -i osd_spec.yaml

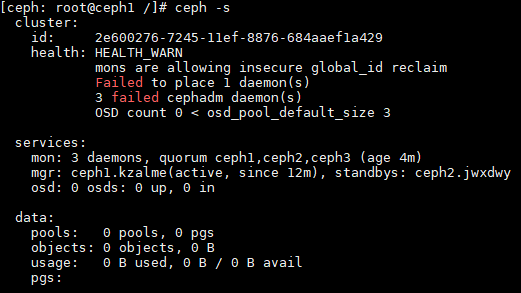

- 查看集群状态。

ceph -s

父主题: 部署Ceph