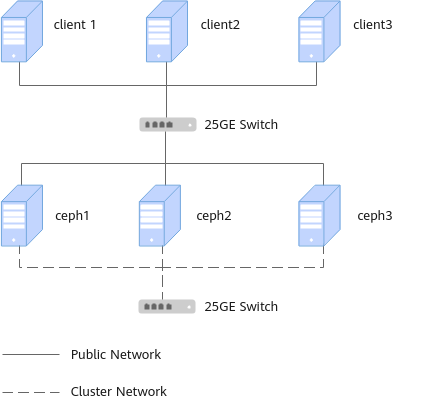

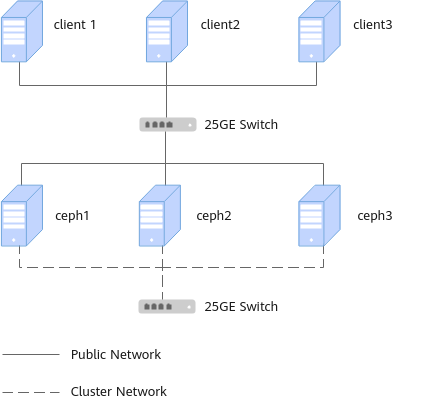

物理组网

Ceph设备物理环境采用“两层网络+三节点”的部署方案,其中,MON、MGR、MDS节点与OSD存储节点混合部署。在网络层面,Public网络与Cluster网络分离,两者均采用25GE光口来进行网络间的通信。

Ceph集群由Ceph客户端和Ceph服务端组成,物理组网如图1所示,实际部署请根据需求设置。

图1 物理组网

硬件配置

Ceph所使用的环境如表1所示。

表1 硬件配置服务器名称

|

鲲鹏服务器

|

|---|

处理器

|

鲲鹏920 5230处理器

|

|---|

核数

|

2*32核

|

|---|

主频

|

2600MHz

|

|---|

内存大小

|

12*16GB

|

|---|

内存频率

|

2666MHz(8*Micron 2R)

|

|---|

网卡

|

IN200网卡4*25GE

|

|---|

硬盘

|

系统盘:RAID1(2*960GB SATA SSD)

均衡型配置数据盘:RAID模式下使能JBOD(12*4TB SATA HDD)

|

|---|

NVMe SSD

|

均衡性配置加速盘:1*ES3600P V5 3.2TB NVMe SSD

高性能配置数据盘:12*ES3600P V5 3.2TB NVMe SSD

|

|---|

RAID控制卡

|

Avago SAS 3508

|

|---|

软件版本

使用到的相关软件版本如表2所示。

表2 软件版本软件

|

版本

|

|---|

OS

|

CentOS Linux release 7.6.1810

|

openEuler 20.03 LTS SP1

|

openEuler 22.03 LTS SP2

|

Ceph

|

建议使用14.2.8或14.2.10版本

|

ceph-deploy

|

2.0.1

|

CosBench

|

0.4.2.c4

|

节点信息

主机的IP网段规划信息如表3所示。

表3 节点信息主机类型

|

主机名称

|

Public网段

|

Cluster网段

|

|---|

OSD/MON节点

|

node1

|

192.168.3.0/24

|

192.168.4.0/24

|

OSD/MGR节点

|

node2

|

192.168.3.0/24

|

192.168.4.0/24

|

OSD/MDS节点

|

node3

|

192.168.3.0/24

|

192.168.4.0/24

|

组件部署

对于Ceph块设备集群,其相关服务组件部署方式如表4所示。

表4 组件部署物理机名称

|

OSD

|

MON

|

MGR

|

|---|

node1

|

12*OSD

|

1*MON

|

1*MGR

|

node2

|

12*OSD

|

1*MON

|

1*MGR

|

node3

|

12*OSD

|

1*MON

|

1*MGR

|

集群检查

可以输入ceph health查看集群健康状态,显示HEALTH_OK表示集群正常。